Interaktive Lichtkunst verbindet digitale Technologien mit räumlicher Wahrnehmung. Sensoren erfassen Bewegung, Klang oder Nähe und übersetzen Daten in dynamische Lichtkompositionen. So entsteht ein Dialog zwischen Werk, Raum und Publikum, in dem Teilhabe, temporale Dramaturgie und ästhetische Erfahrung neu verhandelt werden.

Inhalte

- Sensorik: Best-Practice Setup

- Bewegung: Tracking optimieren

- Publikumserlebnis gestalten

- Kalibrierung, Sicherheit, Flow

- Evaluation und Daten-Feedback

Sensorik: Best-Practice Setup

Für belastbare Interaktionen empfiehlt sich ein mehrschichtiges Sensor-Setup, das kontaktlose Distanzmessung, Flächenerkennung und Präsenzdetektion kombiniert. Kritisch sind Montagehöhe, Sichtlinien und die Lichtumgebung: Infrarot-Sensoren reagieren empfindlich auf Sonnenlicht, Kameras auf niedrige Lux-Werte, Ultraschall auf absorbierende Materialien.Ein knappes Latenzbudget (unter 80 ms bis zur Lichtausgabe) wird durch lokale Vorverarbeitung gesichert: Glättung (EMA/Kalman), Hysterese gegen Flattern und Event-Debouncing direkt am Edge. Zeit- und Takt-Synchronisation (NTP/PTP) stabilisiert Übergaben zu Lichtprotokollen (OSC zu sACN/Art-Net). Redundanz durch überlappende Zonen minimiert Ausfälle; definierte Fallback-Szenen verhindern dunkle Flächen bei Sensorausfall. Datenschutz wird durch Edge-Feature-Extraktion (z. B. Vektor-Events statt Bilder) und kurze Pufferzeiten gewahrt.

- Montage: Starre Befestigung, vibrationsarm, definierte Blickwinkel; Kabelschirmung und PoE/geschirmtes Ethernet in publikumsnahen Bereichen.

- Lichtumgebung: IR-Band prüfen, Streulicht reduzieren; neutral matte Oberflächen bevorzugen, Spiegelungen vermeiden.

- Latenz & Filter: 50-200 Hz Sampling; Exponential-Glättung, Hysterese-Schwellen, adaptives Clipping bei Spitzenlast.

- Redundanz: Überlappende Zonen, Heartbeats, Watchdogs; definierte Safe-States in der Lichtsteuerung.

- Integration: Edge (ESP32/Raspberry Pi) liefert OSC/MQTT-Events; Mapping-Engine triggert sACN/Art-Net/DMX.

Im Betrieb werden Sensor-Knoten als klare Zonen gedacht: Edge-Geräte generieren stabile, semantische Events (z. B. „Eintritt”, „Richtung”, „Verweildauer”) statt Rohdaten. Eine Mapping-Schicht übersetzt diese Ereignisse in Lichtlogik: Schwellen, Kurven und Look-Up-Tabellen für Intensität, Farbe und Bewegung. Fortlaufende Kalibrierung berücksichtigt Tageslicht, Besucherfluss und Temperaturdrift; Logs mit Zeitstempeln erlauben das Erkennen von Drift und Totzonen. Health-Monitoring (Ping, Paketverlust, Sensorrate) zeigt degradierte Knoten frühzeitig.Für großflächige Ensembles ist eine Mischung aus Radar/LiDAR für Präsenz und kamerabasierter Dichteerkennung für Dynamik etabliert; Boden- oder Drucksensoren liefern exakte Trigger an Engstellen.

| Sensor | Reichweite | Stärke | Artefakt | Datenrate |

|---|---|---|---|---|

| ToF/IR | 0,2-5 m | Präzise Distanz | Sonnenlicht-IR | Mittel |

| Ultraschall | 0,2-6 m | Nebel tolerant | Weiche Dämpfung | Niedrig |

| LiDAR 2D | 0,1-12 m | Weite Zonen | Spiegelungen | Mittel |

| Kamera + CV | 1-20 m | Dichte/Tracks | Privacy-Aufwand | Hoch |

| Druckmatte | Boden | Exakte Trigger | Trägheit | Niedrig |

| mmWave Radar | 0,5-10 m | Rauch tolerant | Mehrwege | Mittel |

Bewegung: Tracking optimieren

Robuste Erfassung entsteht durch die Kombination aus präziser Kalibrierung, intelligenter Sensorfusion und konsistenter Koordinatenabgleichung. Tiefe, Position und Geschwindigkeit lassen sich über Depth-Kameras, LiDAR, UWB oder drucksensitive Flächen verschneiden, während Jitter per Kalman-/EMA-Filter geglättet wird. Latenz wird durch Edge-Verarbeitung reduziert, Occlusion Handling via Mehrkanal-Sicht und Prioritätslogik gesichert.Ereignislogik profitiert von Hysterese und kontextabhängigen Schwellwerten, sodass flüchtige Bewegungen nicht zu falschen Triggern führen und stabile Gesten als solche erkannt werden.

- Zonen-Profile: Sensitivität, Filterstärke und Mindestverweildauer pro Raumsegment variieren.

- Confidence-Mapping: Datenströme nach Qualität gewichten, bei Ausfall auf Fallback-Sensoren schalten.

- Synchronisation: Sensor- und Render-Takt auf gemeinsame Zeitbasis, Timestamps normieren.

- Hintergrundmodell: Langsame Licht-/Wetterdrifts auslernen,schnelle Änderungen separat tracken.

- Datensparsamkeit: Vektorielle Bewegung statt Rohbilder; temporäre, anonyme Heatmaps.

| Sensor | Stärke | Grenze | Einsatz |

|---|---|---|---|

| Depth-Cam | Gesten,Tiefe | Lichtempfindlich | Frontale Interaktion |

| LiDAR | Weite,Präzision | Glas/Spiegel | Wegeführung |

| UWB | IDs,Durchdringung | Tags nötig | Gruppendynamik |

| Druckboden | Kontakt sicher | Nur 2D | Takt & Rhythmus |

| IR-Kamera | Dunkelraum | Interferenzen | Marker & Linien |

Die Lichtlogik reagiert optimal,wenn Bewegungsmerkmale in klare Parameter gemappt werden: Geschwindigkeit auf Sättigung,Dichte auf Helligkeit,Richtung auf Farbton,Rhythmus auf Strobing. Kontinuierliche Übergänge verhindern visuelles Ruckeln, während definierte Event-Fenster kollektive Momente hervorheben. Für Publikumsmengen sind Clustering, Kollisionsvermeidung und faire Verteilung visueller Aufmerksamkeit entscheidend; bei Ausfällen greifen Failover-Presets mit konservativen Effekten.Qualitätskontrolle gelingt mit Live-Heatmaps, Log-Trails und A/B-Szenen; saisonale Drift wird über Auto-Tuning von Filtern und Schwellwerten kompensiert, sodass das Lichtsystem auch bei wechselnden Bedingungen verlässlich, flüssig und interpretierbar bleibt.

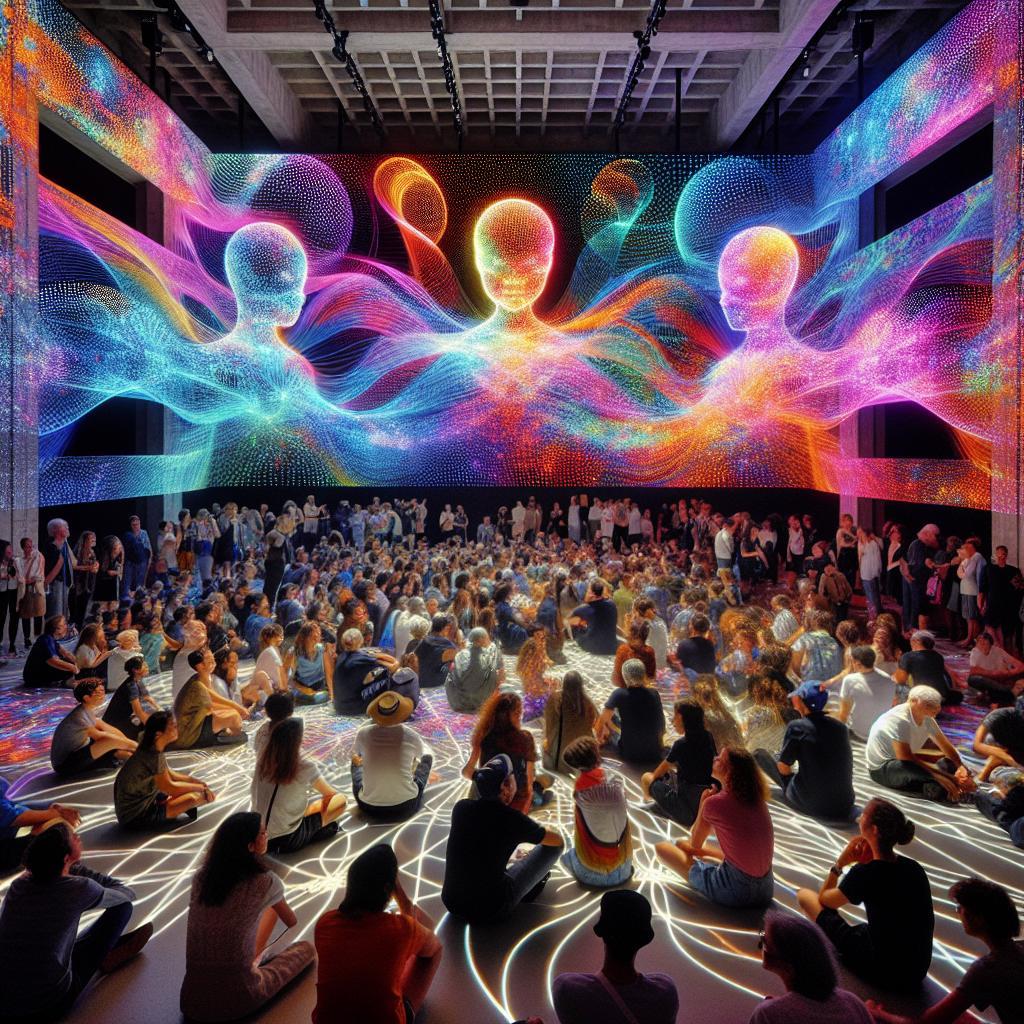

Publikumserlebnis gestalten

Interaktive Lichtwelten überzeugen, wenn Wahrnehmung, Bewegung und Reaktion zu einer schlüssigen Dramaturgie verschmelzen. Entscheidend sind Latenz, Lesbarkeit der Ursache-Wirkungs-Ketten und räumliche Orientierung: sanfte Helligkeitskurven, klar definierte Zonen und konsistente Farbsemantik erleichtern das Verstehen der Mechanik. Adaptive Mappings, die auf Publikumsdichte, Geschwindigkeit und Aufmerksamkeitswechsel reagieren, halten den Fluss lebendig, während mikro-taktile Hinweise (Ton, Schatten, Vibrationen in Objekten) die multisensorische Kohärenz erhöhen. So entsteht ein Gefühl von Agency, ohne kognitive Überlastung oder zufällig wirkende Effekte.

- Onboarding: eindeutige Einstiegssignale und „erste Geste,erster Effekt”

- Feedback-Tiefe: vom schnellen Hinweis bis zur belohnenden Conversion

- Skalierung: Solo-Interaktion bis Gruppenenergieschub ohne Dominanz einzelner

- Rhythmus: Wechsel aus Spannung,Ruhe,Überraschung

- Barrierefreiheit: visuelle Kontraste,akustische Alternativen,taktile Marker

- Sicherheitslogik: sanfte Grenzen,rutschfeste Wege,klare Fluchtlinien

| Sensor-Input | Lichtreaktion | Wirkung |

|---|---|---|

| Handheben | Aufwärts-Kaskade | Ermächtigung |

| Schritte | Lauflicht-Spur | Orientierung |

| Gruppennähe | Farbverschmelzung | Gemeinschaft |

| Stillstand | Langsames Dimmen | Entspannung |

| Stimme | Pulsierende Wellen | Resonanz |

Ein überzeugender Ablauf berücksichtigt Zugänglichkeit,Sicherheitsreserven und crowd-taugliche Choreografien: klare Wege,Ruhezonen,sichtbare Grenzen und Signage als leise Regie. Die Erlebnisdramaturgie folgt idealerweise Phasen wie Orientierung, Exploration, Meisterschaft und Ausklang; Telemetrie und Beobachtung dienen der qualitativen Feinjustierung von Schwellen, Tempi und Emissionsstärken. Redundante Sensorik und Failover-Strategien verhindern Friktion, während transparente Datenethik Vertrauen stiftet. So bleibt das Erlebnis konsistent, skalierbar und erinnerungsstark – unabhängig von Tageszeit, Besucheraufkommen oder Wetterlage.

Kalibrierung, Sicherheit, Flow

Exakte Abstimmung von Sensorik und Lichtsystemen bestimmt Präzision, Reaktionsfreude und Verlässlichkeit der Installation. Entscheidend sind eine belastbare Baseline unter realen Umgebungsbedingungen, konsistente Sensorfusion (z. B. ToF + Vision), ein knappes Latenzbudget für flüssige Rückmeldungen sowie farbtreue Ausgabe über kalibrierte Farbräume und saubere DMX/RDM-Patches. Kontextfaktoren wie Streulicht, spiegelnde Oberflächen, Nebel/Haze oder Publikumsdichte verändern Messwerte und erfordern adaptive Auto‑Kalibrierung mit Grenzwertüberwachung. Ebenso wichtig: Flicker- und Blendfreiheit im Sinne von IEC/EN 62471 (fotobiologische Sicherheit) und IEEE 1789 (Flimmern), damit visuelle Reize begeistern statt zu ermüden.

- Ambient‑Licht‑Offset: Dunkel-/Hellreferenzen,Anti‑Sonnenreflex‑Fenster,IR‑Interferenzfilter.

- Reflexionsfallen: Maskierung glänzender Flächen, Zonen‑Blackout, Cross‑Talk‑Korrektur.

- Drift & Temperatur: Warm‑up‑Zeit,periodische Re‑Kalibrierung,Sensor‑Self‑Check.

- Synchronität: Genlock/Timecode, stabile Frameraten, deterministische Pipeline.

- Fotobiologische Grenzen: Lux‑Deckel, sanfte Rampen, PWM jenseits kritischer Frequenzen.

Sicherheit und Besucherfluss entstehen durch technische Redundanz und räumliche Choreografie. Fail‑Safe-Strategien (Watchdog, Default‑Dimmung, Not‑Stopp), klare Sichtachsen, taktiles Leitsystem und konforme Rettungswegbeleuchtung nach DIN EN 1838 reduzieren Risiko, während Crowd‑Modelle Wartezonen, Einbahn‑Schleifen und Kapazitäten definieren. Die Lichtlogik kann Dichtewerte aus Sensorik in adaptive Flow‑Signale übersetzen: Farbwechsel als sanfte Lenkung, Mikro‑Transitions zur Kollisionsvermeidung, akustische Hinweise unterhalb Aufmerksamkeitsstress. So verbindet eine robuste Sicherheitsarchitektur die Inszenierung mit geordnetem Durchsatz, ohne den immersiven Charakter zu unterbrechen.

| Sensor | Kalibrierfokus | Sicherheitsaspekt | Flow‑Nutzen |

|---|---|---|---|

| ToF/LiDAR | Offset, Mehrwege‑Filter | Abstands‑Guard | Dichte‑Heatmap |

| IR‑Kamera | Gain, IR‑Störschutz | Blendfreiheit | Zielgerichtete Cues |

| Druckmatte | Schwellwerte, Debounce | Not‑Stopp‑Trigger | Einlass‑Zählung |

| UWB/BLE | Anker‑Mapping | Zonen‑Kapa | Routen‑Optimierung |

| Mikrofon | AGC, Noise‑Gate | Alarm‑Detektion | Rhythmische Steuerung |

Evaluation und Daten-Feedback

Wirksamkeit wird über ein datengetriebenes Rückkopplungssystem überprüft: Sensorströme (Positionsdaten, Nähe, Klangpegel) werden zu Metriken wie Verweildauer, Interaktionsrate und Lichtdynamik-Varianz verdichtet. Visuelle Heatmaps, Trajektorien und Takt-zu-Trigger-Korrelationen zeigen, wie Bewegung und Klang die Lichtlogik prägen. Qualitative Signale – etwa Aggregationen aus Kommentaren oder Stimmungsanalyse von Geräuschkulissen – ergänzen quantitative Logs. Durch Anonymisierung, Edge-Verarbeitung und zeitliche Aggregation bleibt der Personenbezug minimiert, während aussagekräftige Muster für kuratorische und technische Entscheidungen erhalten bleiben.

| KPI | Kurzbeschreibung | Beispiel | Ziel |

|---|---|---|---|

| Verweildauer | Ø Zeit pro Zone | 3:45 min | ↑ Aufmerksamkeit |

| Interaktionsrate | Aktive Trigger/Person | 62% | ↑ Beteiligung |

| Licht-Varianz | Intensitätsstreuung | 0,68 | Balanciert |

| Stimmungsindex | Klang/Sentiment | +0,4 | Positiv |

| Latenz | Trigger→Licht | 85 ms | < 120 ms |

Aus den Erkenntnissen entsteht ein kontinuierlicher Verbesserungszyklus: Schwellenwerte für Bewegung und Nähe werden feinjustiert, Lichtkurven und Farbpaletten an Publikumsfluss und Tageszeit angepasst, und Szenen über A/B-Varianten getestet. Edge-Analytics glättet Rauschen, erkennt Anomalien (Überfüllung, Sensor-Drift) und hält die Reaktionslatenz niedrig. Kuratorische Ziele – etwa dramaturgische Verdichtung oder Entzerrung hochfrequenter Bereiche – werden als messbare Hypothesen implementiert und fortlaufend evaluiert.

- Echtzeit-Kalibrierung von Sensor-Gain, Schwarzwert und Schwellen

- Signalglättung via Kalman-/EMA-Filter zur stabilen Lichtausgabe

- A/B-Szenen mit alternierenden Paletten, Mustern und Übergängen

- Load- und Crowd-Detection für Dimmung, Umleitung und Sicherheit

- Privacy-by-Design durch On-Device-Aggregation und Pseudonymisierung

- Tageszeit-Profile zur dynamischen Anpassung von Tempo und Intensität

Was versteht man unter interaktiver Lichtkunst?

Interaktive Lichtkunst verbindet digitale Steuerung, Sensorik und Raumgestaltung. Licht reagiert in Echtzeit auf Umgebungsreize; Farben, Muster und Intensitäten wandeln sich. So entstehen variable Atmosphären und Situationen geteilter Autorschaft.

Welche Rolle spielen Sensoren in solchen Installationen?

Sensoren erfassen Position, Distanz, Berührung, Klang oder Temperatur und liefern Datenströme. Algorithmen interpretieren sie, um Helligkeit, Farbwerte, Richtung und Tempo der Lichtsequenzen zu modulieren und präzise Rückkopplungen zu erzeugen.

Wie beeinflusst Bewegung die visuelle Ausgabe?

Bewegung dient als Auslöser und Regelgröße: Nähe, Geschwindigkeit oder Gesten triggern Übergänge, verschieben Lichtkegel oder verzerren Projektionen.Dadurch bilden sich Feedbackschleifen, in denen räumliche Dynamik und visuelle Struktur sich formen.

Wie wird das Publikumserlebnis gestaltet und gesteigert?

Das Publikumserlebnis profitiert von klaren Interaktionshinweisen, immersiver Klanggestaltung und niedriger Latenz. Narrative Ebenen, Sicherheitszonen und Barrierefreiheit unterstützen Orientierung, Vertrauen und sinnvolle, inklusionsorientierte Beteiligung.

Welche technischen und ethischen Herausforderungen bestehen?

Technische Hürden betreffen Latenz,Kalibrierung,Robustheit und Skalierung. Ethisch bedeutsam sind Privatsphäre bei Datenerfassung, Einwilligung, Inklusion sowie die ökologische Bilanz von Energieverbrauch, Hardwareproduktion, Transport und Wartung.