Die Datenvisualisierung entwickelt sich von einem analytischen Werkzeug zu einer eigenständigen Kunstform.Wo einst Diagramme Fakten strukturierten, entstehen heute immersive Werke, die Muster, Zufall und Algorithmen verbinden. Museen, Medienkunst und Design erschließen neue Ausdrucksweisen, während Fragen nach Ästhetik, Lesbarkeit und Verantwortung das Feld prägen.

Inhalte

- Ästhetik der Datenbilder

- Methoden, Tools und Workflows

- Ethik, Bias und Transparenz

- Kuratorische Strategien

- Empfehlungen für Projekte

Ästhetik der Datenbilder

Daten verwandeln sich zu visuellen Artefakten, sobald Zahlengerüste in Formen, Farben und Rhythmen übersetzt werden. Aus Skalen, Achsen und Netzen entstehen Kompositionen, in denen Balance und Spannung wie in der Malerei wirken. Animationen fügen eine Choreografie der Zeit hinzu, während Projektionen, Plotter und Drucke eine haptische Materialität stiften. Zwischen Genauigkeit und Ausdruckskraft entsteht ein ästhetischer Raum: Algorithmen werden zu Pinselstrichen, Sampling zu Körnung, Aggregation zu Relief. So tritt ein eigenes Vokabular hervor, das vom Bauhaus-Prinzip der Reduktion bis zur generativen Opulenz reicht.

Gestalterische Entscheidungen prägen Wahrnehmung und Bedeutung gleichermaßen. Farbpaletten lenken Emotion und Lesbarkeit, Komposition definiert Blickpfade, Negativraum schafft Ruhe. Transparenzen und Layering erzeugen Tiefe,während Typografie die semantische Hierarchie stützt. Zugleich bleibt die Ethik der Darstellung Teil der Ästhetik: Farbsicherheit, zugängliche Kontraste und klare Maßstäbe verbinden Schönheit mit Verständlichkeit. Wo Daten stille Strukturen bilden, erzeugt ein sparsamer Impuls – ein Glühen, ein Puls – die nötige Dramaturgie.

- Farbdramaturgie: sequenziell vs. divergierend, farbfehlsicht-tauglich, emotionales Temperaturprofil

- Komposition & Maßstab: Makro-Mikro-Wechsel, Fokus durch Größenkontrast

- Rhythmus & Zeit: Easing, Taktung, Pausen als semantische Zäsur

- Textur & Materialität: Körnung, Liniencharakter, Druckverfahren als Ausdruck

- Negativraum & Hierarchie: Atemraum, Priorisierung durch Leere

- Interaktivität: Bewegungslogik als Choreografie, Feedback als Lichtakzent

| Prinzip | Wirkung | Beispiel |

|---|---|---|

| Monochrome Skala | Ruhe, Ordnung | Temperaturverlauf |

| Polar/Spirale | Dynamik, Zyklus | Saisonale Nachfrage |

| Ikonfelder | Konkretheit | Stadtverkehr |

| Minimale Linien | Präzision | Sensorserien |

Methoden, Tools und Workflows

Die künstlerische Übersetzung von Daten beginnt mit der Auswahl und Modellierung bedeutsamer Variablen, gefolgt von einer präzisen Kodierung in Form, Farbe, Bewegung und Raum. Jenseits klassischer Diagramme entsteht Ausdruckskraft durch Kombinationen aus perzeptueller Genauigkeit und ästhetischer Dramaturgie: reduziertes Rauschen, harmonische Farbpaletten, typografische Hierarchien, rhythmische Animationen sowie Sound- oder Haptik-Layer für synästhetische Erlebnisse. Kuratierte Datenproben dienen als „Skizzen”, um visuelle Metaphern zu testen, während datengetriebene Constraints die Komposition disziplinieren und gleichzeitig Spielräume für Abweichung und Überraschung eröffnen.

- Semantisches Mapping: Datenrollen (Messung,Kontext,Annotation) werden klaren visuellen Kanälen zugeordnet.

- Generative Komposition: Algorithmen (Noise, Partikelsysteme, Prozeduren) formen lebendige Muster.

- Narrative Layering: Fokus- und Kontextebenen, Story-Begrenzungen, temporale Sequenzen.

- Interaktive Linsen: Filter, Facetten, Drilldowns, Lens-Overlays statt statischer Views.

- Physisch-digitaler Hybrid: Plotter, LED-Matrizen, AR-Overlays für taktile Präsenz.

Der Produktionsfluss kombiniert Skizzen (Papier, Figma) mit Prototyping in Observable, p5.js oder D3.js, gefolgt von performanter Umsetzung via WebGL/Three.js oder Svelte + d3; Datenvorbereitung erfolgt in Python/R, Feinschliff in Illustrator oder Blender, Installationen mit TouchDesigner. Versionskontrolle, reproduzierbare Pipelines und Barrierefreiheit (WCAG-Kontraste, Screenreader-Labels) sind integraler Bestandteil, ebenso Datenethik (Transparenz, Unsicherheiten, Quellenangaben). Styleguides definieren Farbsysteme (z. B. ColorBrewer/OKLCH), Animationskurven und Interaktionsmuster; Performance-Checks (FPS, LCP) und Usability-Tests sichern die Balance aus Informationsgehalt und künstlerischer Wirkung.

| Phase | Ziel | Tools |

|---|---|---|

| Exploration | Muster finden | Python/R, Observable |

| Skizze | Metaphern testen | Figma, p5.js |

| Produktion | Performanz & Interaktion | D3.js, Three.js, Svelte |

| Politur | Typo & Farbe | Illustrator, Blender |

| Installation | Raumerlebnis | TouchDesigner, LEDs |

| Qualität | Barrierefreiheit & Ethik | WCAG-Checks, Docs |

Ethik, Bias und Transparenz

Wenn Visualisierung zur künstlerischen Geste wird, verschiebt sich nicht nur die Ästhetik, sondern auch die Verantwortung. Kuratierte Datenauswahl, Maßstabsbrüche und verführerische Farbpaletten können Muster überzeichnen, Minderheiten unsichtbar machen oder Korrelationen als Kausalitäten erscheinen lassen. Algorithmisch erzeugte Kompositionen bringen zusätzlich trainierte Vorurteile mit; ohne Transparenz über Quellen, Modelle und Unsicherheit gerät der ästhetische Eindruck zur unbelegten Behauptung. Ebenso zentral sind Urheberrechte und Einwilligung, sobald persönliche Spuren, Sensordaten oder soziale Medien in Artefakte überführt werden.

Ein belastbares Ethos verbindet künstlerische Freiheit mit überprüfbarer Herleitung. Nützlich sind öffentliche Daten-Provenienz, nachvollziehbare Methodenprotokolle und maschinenlesbare Begleitdokumente, die den Übergang von Rohdaten zu Formen erklären. Wo Verdichtung nötig ist, sollten choice Sichten, Fehlerspannen und Limitierungen sichtbar bleiben; wo Modelle generieren, helfen Modellkarten und Audit-Notizen. So entsteht ein Werk, das zugleich inspiriert und überprüfbar bleibt.

- Quellenlage: Datensatz, Erhebungszeitraum, Lizenz, Lücken.

- Bias-Prüfung: Sampling, Labeling, Preprocessing.

- Privatsphäre: Anonymisierung, Aggregation, Zweckbindung.

- Unsicherheit: Konfidenz,Fehlerbalken,Szenarien.

- Gestaltung: Farbschemata barrierefrei, Maßstäbe konsistent.

- Offenlegung: Code, Parameter, Versionierung, Sponsoring.

| Aspekt | Risiko | Gegenmaßnahme |

|---|---|---|

| Sampling | Über-/Unterrepräsentation | Gewichtung, Nachstichprobe |

| Algorithmik | Verstärkung von Stereotypen | Bias-Tests, diverse Trainingsdaten |

| Farbwahl | Irreführende Hierarchien | Perzeptuell gleichmäßige Paletten |

| Aggregation | Simpson-Paradoxon | Drilldowns, Segmentierung |

Kuratorische Strategien

Kuratorische Praxis verschiebt bei datenbasierten Werken den Fokus vom Datensatz als Rohstoff zur ästhetischen, räumlichen und ethischen Übersetzung. Entscheidend sind die Orchestrierung von Metriken, die Dramaturgie der Darstellung sowie die bewusste Reibung zwischen Lesbarkeit und poetischer Ambiguität. Im Ausstellungskontext entstehen Spannungsfelder zwischen Echtzeit und Archiv, zwischen Bildschirmlicht und materieller Präsenz, die durch gestalterische Leitplanken kontrolliert werden.

- Kontextualisierung der Datengrundlage: Herkunft, Zeitfenster, Lücken und Bias transparent machen; Quellen neben das Werk stellen.

- Übersetzung und Reduktion: Encoding-Entscheidungen (Farbe,Form,Bewegung,Ton) mit kuratorischer Intention koppeln; Komplexität gezielt dosieren.

- Materialität: Projektion, LED-Wand, Plotterdruck, textile oder keramische Träger sowie Sonifikation als sinnliche Verankerung nutzen.

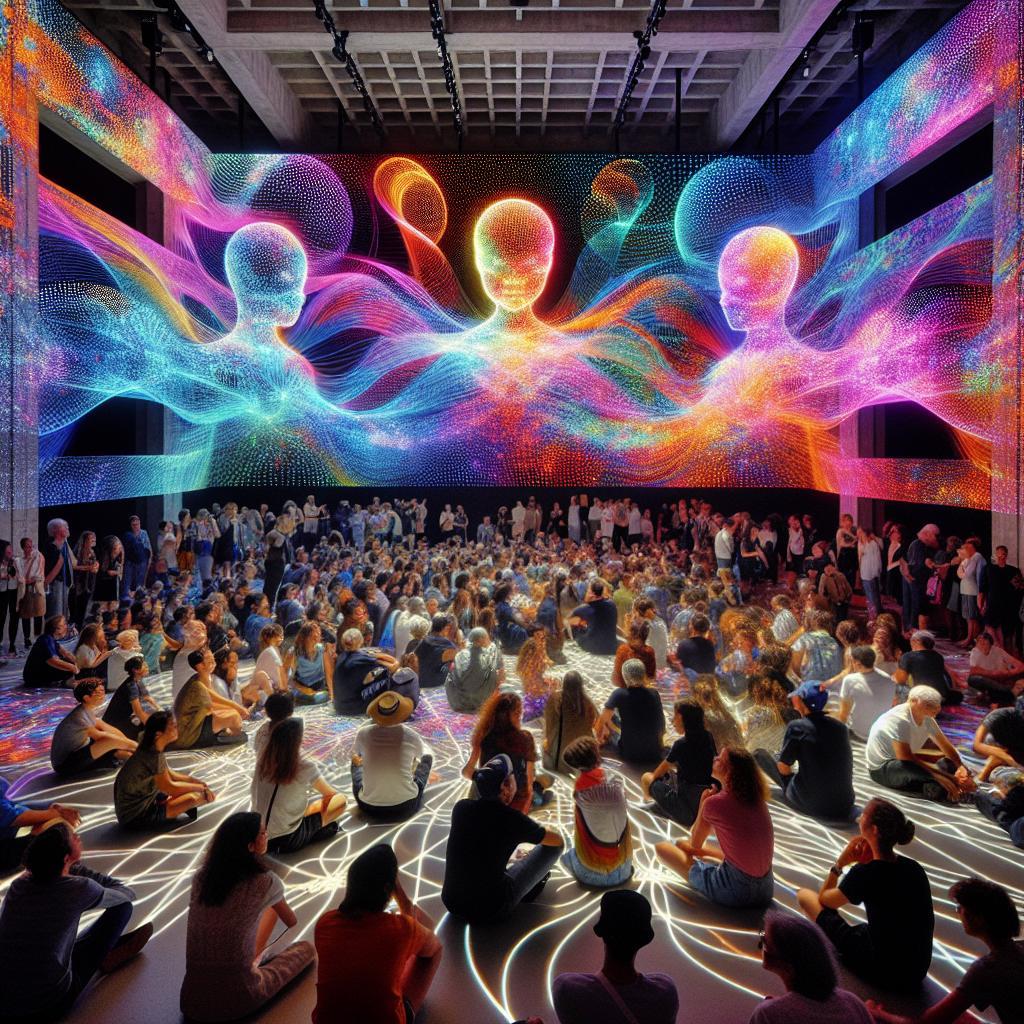

- Interaktivität und Choreografie: Publikumsbewegung, Blickdauer oder Standort als Parameter integrieren; Latenz als ästhetisches Mittel einsetzen.

- Ethik & Datenschutz: Anonymisierung, Aggregation, Einwilligungen und sensible Domänen kuratorisch prüfen; mögliche Schadwirkung antizipieren.

- Barrierefreiheit: Kontraststarke Paletten, semantische Beschreibungen, Audioguides, taktile Modelle und Untertitel implementieren.

Im Betrieb rücken Infrastruktur und Pflege in den Vordergrund: Versionierung, reproduzierbare Pipelines, kontrollierte Aktualisierungsrhythmen und dokumentierte Failure-States sichern die Langlebigkeit.Beschriftungen erweitern sich zu methodischen Begleittexten mit Encoding-Glossar, während Governance-Regeln für Live-Daten (Filter, Verzögerung, Moderation) den öffentlichen Raum des Museums respektieren. Lizenzlagen, Messdaten-Urheberrechte und Kollaborationsverträge werden früh geklärt, um künstlerische Freiheit und rechtliche Sorgfalt zu balancieren.

- Versionierung & Archiv: Snapshots der Datensätze, Checksums, Containerisierung; Emulationspfade für künftige Re-Installationen.

- Betriebsmodi: Offline-Standbild, periodische Feeds oder Echtzeit-Stream je nach kuratorischer Aussage und technischer Resilienz.

- Fehlerästhetik: Ausfälle als sichtbar gemachte Zustände kuratieren (z. B. Ersatzvisualisierung mit Metadaten).

- Rechtemanagement: Klare Attribution, Open-Data-Kompatibilität, Einschränkungen für sensible Inhalte.

| Ziel | Maßnahme | Werkzeug |

|---|---|---|

| Verständnis | Legenden & Encoding-Glossar | Wandtext, Overlay |

| Vertrauen | Offenlegung der Pipeline | Schema, Repo-Link, Checksum |

| Langlebigkeit | Snapshots & Emulation | WARC, Container |

| Beteiligung | Feedback-Schleifen | QR, Umfrage, Moderation |

| Sicherheit | Content-Filter & Delay | Keyword-Listen, Puffer |

Empfehlungen für Projekte

Empfohlene Projektpfade setzen auf das Spannungsfeld zwischen Evidenz und Ästhetik. Im Zentrum stehen vielfältige Datenträger, eine klare visuelle Dramaturgie und reproduzierbare Technik, damit aus Analyze ein eigenständiges Kunstwerk wird. Besonders wirkungsvoll sind Vorhaben,die mit Materialität experimentieren und gleichzeitig eine nachvollziehbare Methodik offenlegen.

- Generative Stadtporträts: Aus offenen Mobilitäts- und Lärmdaten abstrahierte Linienkompositionen, geplottet auf Feinstpapier.

- Klimasonifikation: Temperatur- und CO₂-Serien als Klangflächen und Rhythmusmuster, gekoppelt mit minimalen Partikelvisuals.

- Archiv-Farbpaletten: Automatisch extrahierte Pigmentwelten aus Museums-APIs, kuratiert zu chromatischen Kartografien.

- Lyrik-Topografien: Semantische Netze aus Gedichtkorpora als typografische Landschaften mit negativen Räumen.

- Taktile Diagramme: 3D-gedruckte Reliefs für barrierefreie Datenkunst, kombiniert mit Braille-Beschriftung.

Für belastbare Artefakte empfiehlt sich ein definierter Produktionspfad mit Datenhygiene, sauberer Provenienz, ethischer Kontextualisierung und konsequenter Barrierefreiheit (kontrastsichere Paletten, Alt-Texte, taktile Alternativen). Sorgfältige Lizenzwahl, skalierbare Rendering-Pipelines und kurze Iterationszyklen erleichtern Ausstellung, Reproduktion und Langzeitpflege.

| Projekt | Datenquelle | Tool | Ausgabe |

|---|---|---|---|

| Generative Stadtporträts | OSM,Lärm-Open Data | Processing | Plotter-Print |

| Klimasonifikation | NOAA,Copernicus | Python + Sonic Pi | Audio/Video |

| Archiv-Farbpaletten | Museums-APIs | Python,Adobe | Poster-Serie |

| Taktile Diagramme | UN-Stat,OpenBudgets | Blender,3D-Druck | Relief-Objekt |

Was macht Datenvisualisierung zur Kunstform?

Datenvisualisierung wird zur Kunst,wenn über bloße Erklärung hinaus ästhetische Entscheidungen,Materialität der Daten und konzeptuelle Setzungen betont werden. Form, Farbe und Komposition erzeugen Ambivalenz, Emotion und Reflexion neben Erkenntnis.

Welche historischen Einflüsse prägen diese Entwicklung?

Von frühen Statistikgrafiken und Infografiken über Bauhaus, Minimalismus und Konzeptkunst bis zur Netzkunst prägen viele Strömungen die Entwicklung. Reduktion, Systemästhetik und Prozesskunst verbinden sich mit Informationsdesign und Interaktivität.

Welche Rolle spielen Algorithmen und KI?

Algorithmen strukturieren Muster, berechnen Formen und erzeugen generative Variationen. KI erweitert dies um Stiltransfer, Clustering und Simulation. Gleichzeitig rücken Fragen nach Bias, Datenherkunft, Transparenz und geteilter Autorenschaft in den Fokus.

Wie verändert Interaktivität die Wahrnehmung?

Interaktive Visualisierungen verlagern Wahrnehmung vom Betrachten zum Handeln. Durch Navigation, Filter und Sensorik entsteht ein verkörpertes Erleben. Zeitliche Dimension, Feedback-Schleifen und spielerische Mechaniken vertiefen Interpretation und Bindung.

Welche ethischen Fragen stellen sich?

Zentrale Themen sind Datenschutz, Einwilligung und Repräsentationsgerechtigkeit. Ästhetisierung von Leid,suggestive Skalen und Auswahlprozesse können manipulativ wirken. Transparenz über Datenquellen, Modelle und Ziele wird daher essenziell.