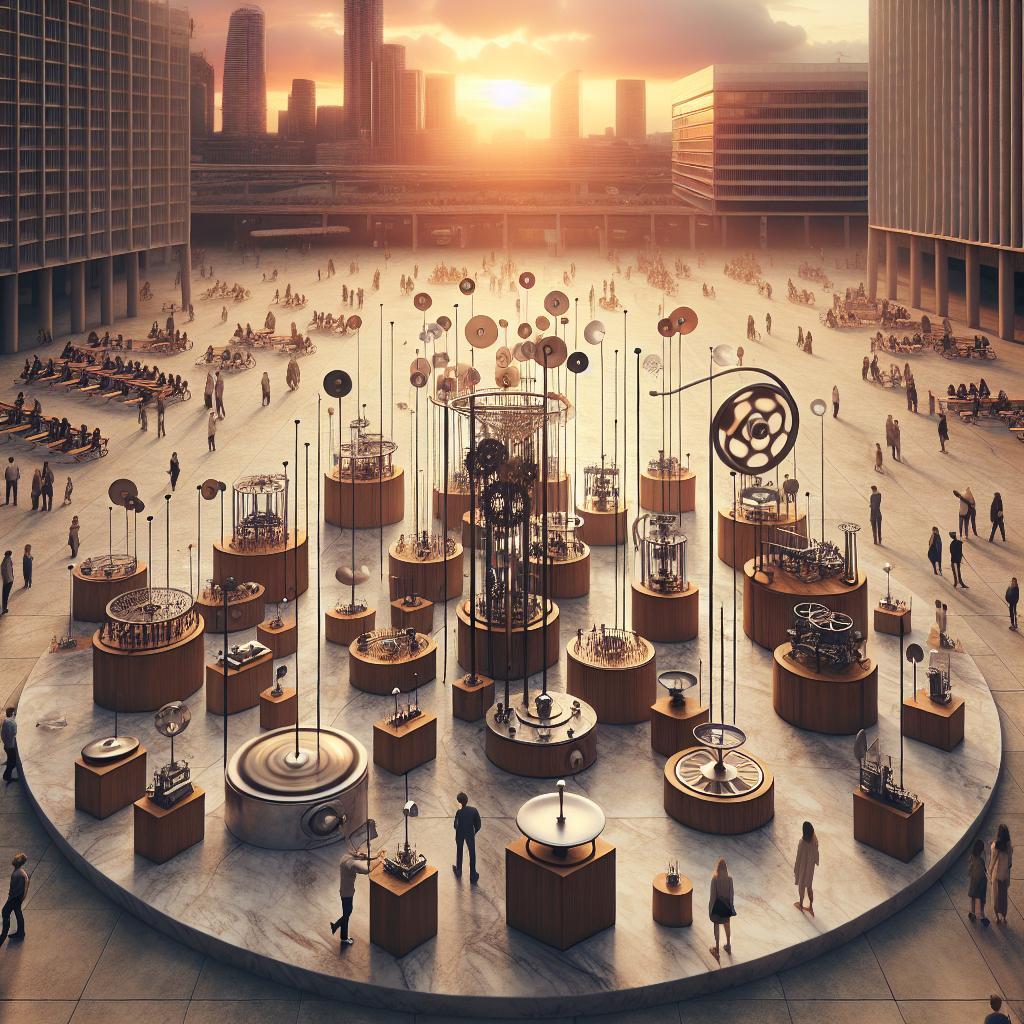

Kunst trifft Robotik: Mechanische Skulpturen verschmelzen kinetische Ästhetik mit programmierter Präzision. Der Beitrag beleuchtet Entwurf und Aufbau solcher Werke – von Materialwahl und Mechanik über Sensorik,Mikrocontroller und Algorithmen bis zu kreativer Programmierung. Im Fokus stehen Interaktion, Steuerung, Sicherheit, Wartung und die Poetik der Bewegung.

Inhalte

- Skulpturdesign und Kinematik

- Antriebe: Motoren und Aktorik

- Controller, Sprachen, IDEs

- Sensorik, Regelung, Sicherheit

- Bewährte Praktiken, Tuning

Skulpturdesign und Kinematik

Form folgt Bewegung – in mechanischen Skulpturen modelliert die Kinematik die Silhouette. Ein präzises Freiheitsgrad-Budget, sauber definierte Gelenktypen (Dreh-, Schub-, Kugelgelenk) und abgestimmte Übersetzungen legen Ausdruck und Zuverlässigkeit fest. Massenverteilung, Gelenkspiel und Dämpfung beeinflussen Geräusch, Laufruhe und Energiebedarf; Materialwahl zwischen steifen Links, nachgiebigen Elementen und Seilzügen steuert Charakter und Sicherheit. Parametrische Modelle mit Kollisionsprüfungen, Toleranzen für Lager und eine frühe Simulation von Trägheiten verhindern spätere Iterationskosten und ermöglichen elegantes Verzahnen von Formteilen mit verdeckter Mechanik.

- Drehpunkte hinter die sichtbare Kontur setzen, um Technik zu entmaterialisieren

- Seilzug statt Zahnrad, wenn sanfte, geräuscharme Bewegung gewünscht ist

- Spiel einkalkulieren und durch Federvorspannung entklappern

- Massenträgheit reduzieren: kurze Links, leichte Endeffektoren

- Phasenlage gekoppelter Kurbeln bewusst für Rhythmus nutzen

- Dämpfer aus Silikon/Gummi zur Schwingungsberuhigung integrieren

Gestische Absichten korrespondieren mit typischen Ketten: Viergelenke erzeugen organische Bögen, Kurvenscheiben liefern präzise Konturen, Pan-Tilt-Gimbals orientieren Blickachsen, Stewart-Plattformen formen volumetrische Transformationen. Ausdruck entsteht durch Bewegungsprofile wie Sinus, S-Kurve oder stochastische Modulation sowie durch mikrokinematische Effekte (Rückfederung, Nachlauf).Kopplungen und Nachgiebigkeit dienen als physische Filter, die Ruck unterdrücken und Oberflächen lebendig machen, während modulare Knoten die Wartung vereinfachen und serielle wie parallele Ketten kombinierbar halten.

| Intention | Kinematik | Antrieb | Profil |

|---|---|---|---|

| Atmung | Exzenter / Kurvenscheibe | Getriebemotor | Sinus |

| Blickfolge | 2-DOF Pan-Tilt | Servos | S-Kurve |

| Wogen | Gekoppeltes Viergelenk | DC + Kurbel | Phasenversatz |

| Metamorphose | Stewart-Plattform | Linearaktuatoren | Bézier |

| Flattern | Tensegrity / Seilzug | Mikro-Servo | Noise/LFO |

Antriebe: Motoren und Aktorik

In kinetischen Skulpturen schreiben Antriebe die Grammatik der Form: von schwebend leichten Gesten bis zu kraftvollen Transformationen. Die Auswahl des Motors bestimmt Drehmoment, Geschwindigkeit und Feinfühligkeit, während Übersetzungen und Lager das Bewegungsspektrum verfeinern. BLDC liefern fließende,leise Rotationen; Schrittmotoren überzeugen mit Wiederholgenauigkeit; Servoantriebe kombinieren Kraft mit präziser Rückmeldung; Linearaktores und Solenoide erzeugen unmittelbare Hubimpulse; Pneumatik sorgt für organische,federnde Dynamik. Materialkopplungen wie Riemen, elastische Kupplungen oder spielfreie Harmonic-Getriebe beeinflussen Spiel, Compliance und Akustik - entscheidend für die sinnliche Qualität der Bewegung.

- Drehmoment vs. Trägheit: Schwungmassen glätten, erschweren jedoch Beschleunigung; stromregelnde Treiber und richtige Polpaarzahl balancieren.

- Getriebeuntersetzung & Spiel: Harmonic/Planetengetriebe für Präzision; Riemen reduzieren Geräusche und dämpfen Schwingungen.

- Akustik & Haptik: Mikroschrittprofile, FOC und weiche Lager entkoppeln Motorgeräusche vom Skulpturkörper.

- Energiepfad: Lastspitzen abfangen (Pufferkondensatoren, Bremswiderstände), thermische Reserven für Dauerbetrieb einplanen.

Die Programmierung übersetzt Intention in Trajektorien. S-Kurven und ruckbegrenzte Profile formen lebendige Bewegungen; Closed-Loop mit Encoder, Strom- und Lagefeedback stabilisiert unter wechselnden Lasten. Sensorfusion (Hall,IMU,Kraftsensorik) ermöglicht Interaktion,während Protokolle wie CANopen,EtherCAT oder DMX/MIDI Bewegungen mit Licht und Klang koppeln. Zustandsmaschinen und Echtzeit-Tasks trennen Choreografie von Sicherheit: Softlimits, Endschalter, Stromgrenzen und Watchdogs sichern den Betrieb; Homing-Routinen und Kalibrierfahrten halten Präzision über lange Spielzeiten.

| Antrieb | Charakter | Steuerung | Geräusch | Aufgabe |

|---|---|---|---|---|

| Schrittmotor | präzise, ruckarm | Mikroschritt, Closed-Loop optional | mittel | Raster-/Zeigerbewegung |

| BLDC | flüssig, dynamisch | FOC, Encoder | niedrig | kontinuierliche Rotation |

| Servoantrieb | kraftvoll, reaktiv | PID, Feldbus | mittel | präzise Positionierung |

| Linearaktor | direkt, kompakt | PWM, Endschalter | niedrig | Hub-/Klappmechanik |

| Solenoid | impulsiv | Treiber, Strombegrenzung | hoch | Taktiles Klicken |

| Pneumatik | weich, federnd | Ventile, Druckregelung | niedrig-mittel | organische Gesten |

Controller, Sprachen, IDEs

Die Wahl des Rechenherzens entscheidet über Ausdruck und Zuverlässigkeit der kinetischen Komposition: Von 8‑Bit‑Klassikern bis zu 32‑Bit‑Powerpaketen prägen Taktfrequenz, Timer und Interrupt-Architektur die Feinzeichnung von Bewegungen.Für filigrane Gesten sind Determinismus, sauberes PWM und galvanische Trennung zentral; für narrative Choreografien zählen Echtzeit‑Zustandsmaschinen, Sensorfusion und vernetzte Szenensteuerung. Sprachen und Toolchains formen dabei die künstlerische Grammatik: C/C++ für harte Zykluszeiten, MicroPython für schnelle Skizzen, Rust für Sicherheit in komplexen Installationen. Protokolle wie CAN, I²C und SPI binden Treiberstufen, Endschalter und IMUs ein; MIDI, OSC oder MQTT öffnen die Bühne für Klang, Licht und Remote‑Regie.

- Rechenplattform: AVR/Arduino für Prototypen, ARM‑Cortex (STM32, RP2040) für präzise Multi‑Achsen, ESP32 für WLAN/Bluetooth‑Interaktion.

- Motorik: Servos, Schrittmotoren, BLDC; S‑Kurven‑Profile, Feed‑Forward, Strombegrenzung, Not‑Halt.

- Kommunikation: CAN‑Bus für robuste Installationen, RS‑485 in langen Kabelwegen, OSC/MIDI für performative Steuerung.

- Sprache & Runtime: C/C++ für harte Latenzbudgets, Micro/CircuitPython für Iteration, Rust für Speichersicherheit.

- IDEs & Build: Arduino IDE für Skizzen, PlatformIO in VS Code für Mehr‑Targets, Thonny für MicroPython, STM32CubeIDE für HAL‑Workflows.

| Controller | Stärke | Sprachen | IDE |

|---|---|---|---|

| Arduino Uno | Schnelle Skizzen | C/C++ | Arduino IDE |

| ESP32 | Funk & Sensorik | C++/MicroPython | VS Code + PlatformIO |

| Raspberry Pi Pico | Präzise PWM | MicroPython/C | Thonny/VS Code |

| STM32 (F0/F4) | Echtzeit‑Achsen | C/C++/Rust | STM32CubeIDE/PIO |

| Teensy 4.1 | Audio & Tempo | C++ | Arduino IDE/PIO |

Produktive Entwicklungsumgebungen bündeln Build‑Profile, serielles Logging, Unit‑Tests für Kinematik und Hardware‑in‑the‑Loop‑Prüfstände. Bibliotheken für S‑Kurven, PID/State‑Space und Task‑Scheduler liefern kontrollierbare Dynamik; Konfigurationen über JSON/OSC machen Bewegungsphrasen parametrierbar. Mit Git‑Versionierung,reproduzierbaren Toolchains (PlatformIO) und Board‑spezifischen HALs entsteht ein Workflow,der vom Atelier‑Prototyp bis zur dauerhaft installierten Skulptur konsistente Ergebnisse liefert - auditierbar,wartbar und synchronisierbar mit Licht‑ und Sound‑Systemen.

Sensorik, Regelung, Sicherheit

Präzise Wahrnehmung verwandelt mechanische Skulpturen in reaktive Systeme: IMU, Hall-/Wegsensoren, ToF/LiDAR, Mikrofone und Kraft-/Drucksensoren liefern Rohdaten, die über Sensorfusion zu stabilen Zustandsgrößen (Lage, Geschwindigkeit, Kontakt, Nähe) verdichtet werden. Für flüssige Bewegung koppeln PID mit Anti-Windup oder modellbasierte Ansätze (MPC) Regelabweichungen an jerk-limitierte Trajektorien; Friction Feedforward und Gravitationskompensation minimieren Stellspitzen. Rauschbehandlung (Median/Butterworth), Oversampling und zeitstempelgenaue Puffer sorgen für niedrige Latenz bei gleichzeitiger Robustheit; Ereignis-Trigger (Klick, Applaus, Schattenwurf) können über Schwellen, Hysterese und Onset-Detektion in choreografische Zustandswechsel übersetzt werden.

- Sensorfusion: Komplementär-/Kalman-Filter für Lage und Driftfreiheit

- Regelung: Feedforward, Anti-Windup, Zustandsbeobachter bei elastischer Mechanik

- Dynamik: Soft-Limits, S-Kurven, Kollisionserkennung über Kraft-/Stromsignaturen

- Diagnostik: Heartbeat, Watchdog, CRC auf Busprotokollen, Plausibilitätsprüfungen

| Kanal | Sensor | Regelgröße | Abtastrate | Sicherheitsgrenze |

|---|---|---|---|---|

| Bewegung | Encoder + IMU | ω, θ | 1 kHz | ωmax = 120°/s |

| Proximität | ToF/LiDAR | Distanz | 100 Hz | dmin = 0,4 m |

| Kontakt | FSR/Kraft | F | 500 Hz | Fmax = 20 N |

| Thermik | NTC/DS18B20 | T | 10 Hz | Tmax = 70°C |

Sicherheit beginnt mit Risikobeurteilung und endet in durchgängigem Design: STO (Safe Torque Off) und SLS (Safely Limited Speed) begrenzen Energie, Not-Halt zweikanalig entkoppelt Logik von Leistung, und Safe-State-Strategien berücksichtigen Schwerkraft, Klemmpunkte und Trägheit. Redundante Sensorik mit Kreuzvergleich, Timeout- und Plausibilitätslogik, thermische Derating-Kurven sowie Ereignisprotokollierung (Blackbox) erhöhen Nachvollziehbarkeit. Mit konservativen Grenzwerten, Debounce auf Eingängen, definierter Fehlersuche (FMEA) und eindeutigem Rückkehrpfad aus dem Störfall bleibt die Skulptur vorhersagbar und publikumstauglich.

Bewährte Praktiken, Tuning

Stabile Bewegung und verlässliche Ausdruckskraft mechanischer Skulpturen entstehen aus präziser Mechanik, sauberer Elektrik und robuster Software-Architektur. Zentral sind reproduzierbare Zeitsignale, entstörte Sensorik sowie thermisch und akustisch bedachte Antriebsprofile. Bewährt haben sich:

- Saubere Spannungsversorgung: Separate Rails für Logik/Antrieb,großzügige Puffer-Elkos,sternförmige Masseführung.

- Mechanische Entkopplung: Elastomere Lager, Massenträgheit dort erhöhen, wo Resonanzen auftreten; spielfreie Getriebe.

- Modulare Steuerlogik: Zustandsmaschinen, klar getrennte I/O-, Regel- und Choreografie-Schichten; hot-swapbare Presets.

- Deterministische Zeitbasis: Feste Taktgeber, Priorisierung zeitkritischer Tasks, entkoppelte Kommunikations-Queues.

- Sicherheitskonzepte: Endschalter, Strom- und Temperaturlimits, Watchdog, definierte Fehlerbewegungen (Safe Pose).

| Komponente | Parameter | Faustregel | Effekt |

|---|---|---|---|

| Servo/Joint | PID Kp/Ki/Kd | Kp bis leichte Überschwinger, Ki klein, Kd dämpft | Präzision vs. Schwingung |

| Schrittmotor | Mikroschritt, Strom | 1/16-1/32; 70-85% Nennstrom | Ruhe, Drehmoment |

| Motion | Beschleunigungsrampen | S-Kurven für Übergänge | Vibration, Klang |

| Sensor | Filter/Entprellung | LP 10-50 Hz; 5-20 ms | Stabilität, Latenz |

| Treiber | PWM-Frequenz | > 20 kHz | Geräusch, Wärme |

Feinabstimmung folgt einem iterativen Ablauf mit isolierter Parameteränderung, synchronem Logging (Positionsabweichung, Strom, Temperatur, Audio-Pegel) und objektiven Metriken (RMS-Fehler, Anlaufzeit, Energie pro Zyklus). Künstlerische Dynamiken profitieren von Easing-Kurven (Bezier, sinusförmig) und amplitudeabhängiger Dämpfung; Choreografien werden als zeitgestempelte Keyframes mit Interpolation hinterlegt. Umgebungsfaktoren wie Temperaturdrift und Raumakustik werden über Profil-Presets adressiert, während präventive Pflegepläne (Schmierung, Riemenspannung, Nullpunktabgleich) die Langzeitstabilität sichern und die gewünschte haptisch-akustische Signatur der Skulptur bewahren.

Was zeichnet mechanische Skulpturen in der Kunstrobotik aus?

Mechanische Skulpturen verbinden kinetische Elemente mit elektronischer Steuerung. Sie erzeugen Bewegung, Klang oder Licht und reagieren oft auf Umgebungssignale. Ziel ist eine erfahrbare Übersetzung von Konzepten in präzise, wiederholbare Abläufe.

Welche Komponenten steuern Bewegung und Interaktion?

Zentrale Elemente sind Aktoren wie Servos, Schrittmotoren oder Pneumatik, ergänzt um Sensoren für Nähe, Berührung, Licht und Klang. Mikrocontroller oder Echtzeitrechner koordinieren Signale, entkoppeln Lasten und sorgen für reproduzierbare Abläufe.

Wie werden Bewegungen programmiert und synchronisiert?

Programmierung erfolgt über Zustandsmaschinen, Keyframe-Animation oder prozedurale Generierung. Timing wird per Echtzeituhr, PID-Reglern und kinematischen Modellen präzisiert. Synchronisation mit Audio/Video gelingt via MIDI, OSC oder Timecode.

Welche Materialien und Fertigungsmethoden kommen zum Einsatz?

Strukturen entstehen aus Aluminium,Stahl,Holz oder Kunststoffen; komplexe Teile via 3D-Druck,CNC-Fräsen und Laserschneiden.Lager,Riemen und Getriebe sichern Mechanik. Kabelmanagement und modulare Gehäuse erleichtern Wartung und Erweiterung.

Welche Sicherheits- und Wartungsaspekte sind relevant?

Sicherheitskonzepte umfassen Not-Aus, Drehmomentbegrenzung, Abdeckungen und Sensorgrenzen. Softwareseitig helfen Watchdogs, Logging und Fallback-Zustände. Regelmäßige Inspektionen von Befestigungen, Schmierung und Kalibrierung sichern Betrieb.